10.5.2. Алгоритм

Алгоритм состоит из двух этапов: первого – этапа обучения, во время которого накапливается информация о признаках на основании уже имеющегося опыта и оценивается информативность выбранных признаков, и второго – этапа классификации, на котором выносится решение о пригодности субъекта к определенной деятельности.

Обучение. Предполагается, что на основании предыдущего опыта можно выделить группы субъектов «А» и «В», которые отражают наше понимание пригодности (или непригодности) к данной деятельности и являются определенными эталонами для дальнейшего прогнозирования пригодности. Ряд практических вопросов, связанных с образованием классов «А» и «В», будет рассмотрен ниже. Далее предполагается, что имеется какой-то набор признаков v1, v2,…, vn, существенность которых для определения профессиональной пригодности можно и не знать. Теперь можно построить множество векторов {vA} и {vB}, соответственно характеризующих группы субъектов «А» и «В».

Процесс обучения состоит в получении оценки дискретных одномерных распределений вероятностей признаков v1, v2,…, vn для класса «А»: fA1(v1), fA2(v1),…, fAn(v1) для класса «В»: fB1(v1), fB2(v1),…, fBn(v1).

Предполагается, что v1, v2,…, vn слабо зависимы. Если, однако, этого нет, то для увеличения эффективности процедуры в рассмотрение вводятся сложные признаки – синдромы, определение которых можно получить на основании опыта и теоретических соображений или же используя соответствующий математический аппарат. Построение одномерных распределений существенно облегчает процесс обучения, а в случае слабой зависимости потери информации при этом невелики.

Если классы «А» и «В» многочисленны, то можно получить достаточно хорошую оценку требуемых вероятностей {fА(vj)} и {fB(vj)} (i = 1, 2, …, n).

В тех же случаях, когда численности классов «А» и «В» невелики, приходится прибегать к грубому квантованию признаков на 2–3–4 градации. Практическая проверка показывает, что при наличии в группе 25–30 человек и соответствующем квантовании можно получить удовлетворительные результаты.

Полученные в результате обследования данного контингента лиц показатели могут иметь различную ценность для целей прогнозирования профессиональной пригодности. Поэтому следующим этапом «обучения» является оценка информативности признаков.

Признак будет тем более информативным, чем больше различие между его распределениями у представителей класса «А» и «В». Оценка информативности признака v1 может выражаться величиной Pj – вероятностью того, что распределения fАj(vj) и fBj(vj) различны. Это достигается при помощи вычисления ?2. Интуитивно ясно, что вероятность Pj может быть хорошей мерой информативности признака vj при данной конкретной классификации. Необходимо отметить, что признаки, информативные в одном случае, могут оказаться совсем не информативными для решения задачи профотбора других специалистов.

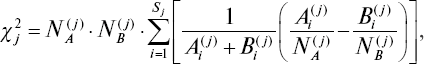

Вычисление c2 производилось по формуле:

где NA(j)и NB(j)– общее число лиц соответственно в классах «А» и «В», данные которых использовались при построении распределений для j-го признака;Ai(j)и Bi(j)– частоты появления индивидов в i-й градации j-го признака для сравниваемых классов; Sj – число градаций для j-го признака.

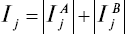

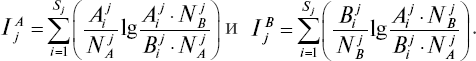

Вероятности Pj определялись по таблицам Л. Большова и Н. Смирнова [52]. Оценка информативности может быть также получена и при помощи расстояния Кульбака. В принятых здесь обозначениях и несколько измененной форме это расстояние имеет вид:

где

Эта мера имеет ряд преимуществ, особенно при теоретических исследований. Для практики представляет интерес возможность измерения значимости признаков v1(j = 1, 2, …, n) отдельно для вынесения решения о принадлежности v к {vA} или {vB} (соответственно слагаемые IAjи IBj).

Используя ту или другую меру, признаки целесообразно расположить по их убывающей информативности, а те из них, которые неинформативны (P слишком велико или I – мало), использовать не надо. Если окажется, что информативных признаков осталось мало, то необходимо ввести новые признаки.

Процесс «обучения» можно считать законченным, когда оценки распределений fАj(vj) и fBj(vj) (j = 1, 2, …, n) достаточно надежны, признаки упорядочены по их информативности и их достаточно много.

Классификация (решающее правило). При классификации можно допустить две ошибки. Субъект из класса «А» может быть ошибочно отнесен к классу «В» и, наоборот, субъект из класса «В» может быть ошибочно причислен к классу «А». Первую из указанных ошибок классификации будем обозначать через ?, а вторую через ?.

Вероятности ошибок ? и ? определяются до проведения классификации. При выборе этих вероятностей должна быть учтена важность той или другой ошибки классификации, а также реальная ситуация, возникшая при решении данной конкретной задачи.

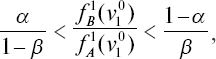

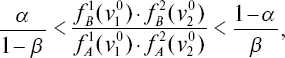

Пусть при обследовании субъекта S были получены признаки v10, v20,…, Vn0 (они приведены здесь в порядке их убывающей информативности). Пусть на основании здравого смысла выбраны допустимые вероятности ошибок ? и ?. Рассмотрим отношение вероятностей, соответствующих первому признаку:

Если это отношение будет меньше, чем

то это будет означать, что полученное значение признака v10 настолько вероятнее для класса «А», что можно с выбранным уровнем надежности (?, ?) утверждать, что данное лицо относится к классу «А» (пригодно к данной профессиональной деятельности). Если это отношение

то с тем же уровнем надежности принимается решение о непригодности к рассматриваемой деятельности. Если

то информация, заключенная в признаке, недостаточна для отнесения к классам «А» и «В» и рассматривается следующий признак v20.

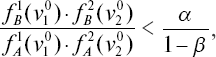

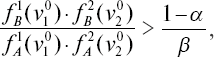

Если

то выносится решение об отнесении индивида в класс «А»; если

то в класс «В».

Когда же

то рассматривается значение третьего признака v30 и т. д.

Если, перебрав все признаки, не удается отнести субъекта к тому или иному классу с данным уровнем надежности, то есть рассматриваемое отношение не выходит за пределы требуемых рубежей, то это означает, что имеющиеся результаты обследования не позволяют сделать прогноз с выбранным уровнем надежности. В этих случаях можно понизить этот уровень и таким образом сделать прогноз или обратиться за дополнительной информацией.

При отсутствии дополнительной информации для минимизации вероятности ошибки целесообразно построить два распределения отношения правдоподобия по всем признакам соответственно для групп «А» и «В» и на основе этих распределений выбрать один порог. Особенности распределения обычно таковы, что этим порогом редко бывает 1.

Как известно, в схемах последовательного статистического анализа [58] процедуры обосновываются для однородного случая, когда fA1(v1) = fA2(v2) =… = fAn(vn) и fB1(v1) = fB2(v2) =… = fBn(vn)

Однако нетрудно показать, что зависимость порогов от вероятности ошибок ? и ? переносится и на случай неодинаковых распределений, возникающих в диагностической задаче.

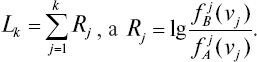

Практически удобно иметь дело не с отношениями вероятностей, а с логарифмом этого отношения. Тогда все вычисления сводятся к последовательному сложению.

Итак, определение принадлежности векторов v (v1, v2, …, vn) к множеству {vA} или {vB} осуществляется следующим образом. Последовательно вычисляются величины L1, L2, …, Lk, где

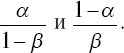

Каждое вычисленное Lk сравнивается с порогами

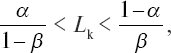

Если при некотором k < n

то вычисляется Lk+1. Если же

то v ? {vB}; если же

то v ? {vB}.